Carlos Zuñiga

CEO & Co-founder

En Atémpora® diseñamos tiendas en línea con Shopify, escalables y con enfoque en conversión.

El estudio se llama "LLMs Reproduce Human Purchase Intent via Semantic Similarity" y lo que demuestra es incómodo para cualquiera que haya gastado dinero en paneles de consumidores tradicionales: la inteligencia artificial puede replicar la intención de compra humana con 90% de fiabilidad.

No el 60%. No "más o menos". El 90%.

Eso es casi tan confiable como repetir el mismo estudio con humanos reales dos veces.

El problema con pedirle números a una IA

Si alguna vez le preguntaste a ChatGPT "¿comprarías este producto? Califica del 1 al 10", probablemente obtuviste un 6 o un 7. Tibio. Neutral. Inútil.

No es culpa tuya. Es que los modelos de lenguaje tienen un sesgo documentado hacia las respuestas seguras. Cuando les pides una calificación numérica directa, colapsan hacia el centro de la escala. Los investigadores llaman a esto "colapso de varianza".

El resultado es una distribución de respuestas que no se parece en nada a cómo responden los humanos reales. Cuando compararon estadísticamente las calificaciones numéricas de la IA contra datos de 9,300 respuestas humanas, la similitud fue pésima.

Fin del experimento, ¿no?

No exactamente.

El método que sí funciona

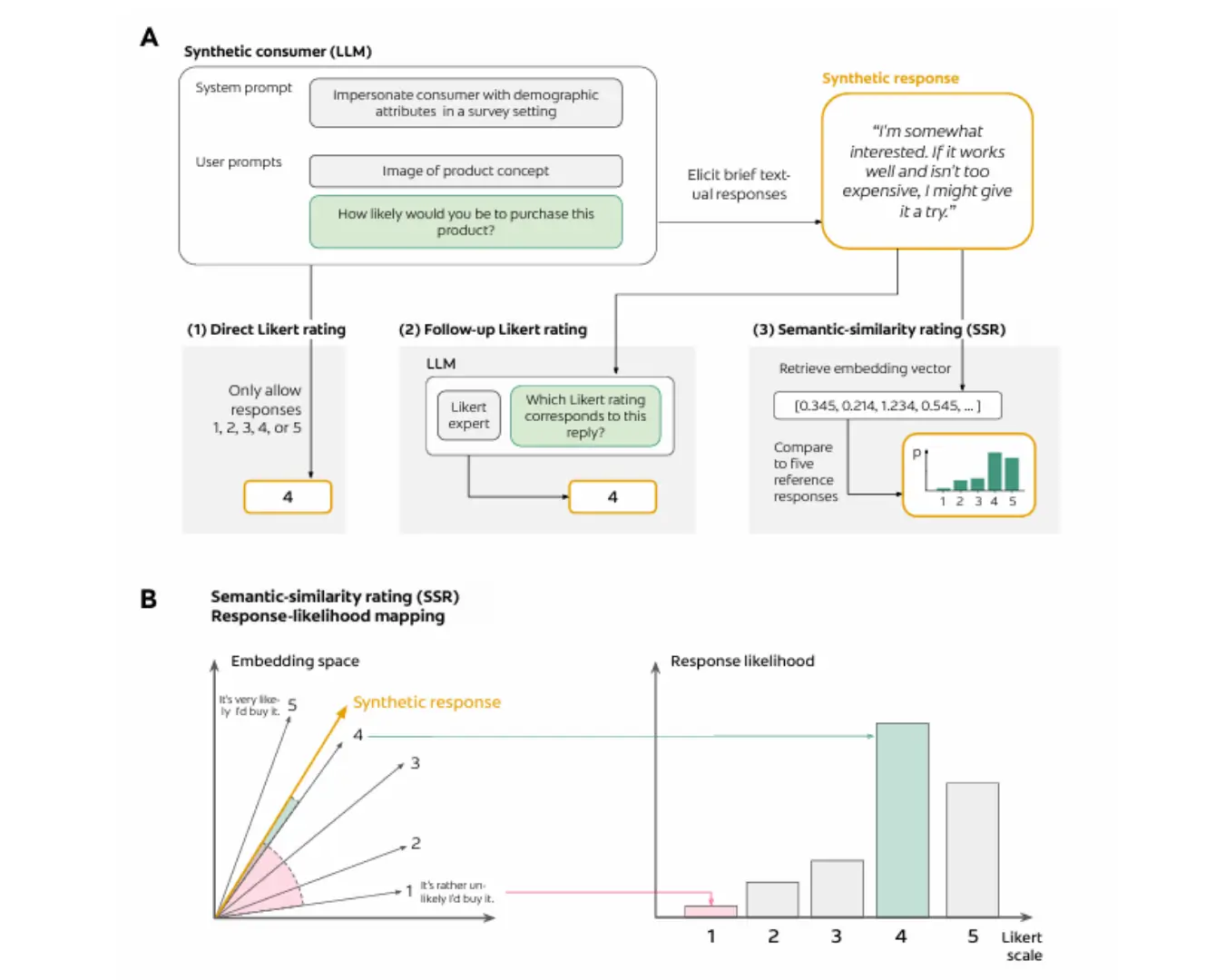

Los investigadores propusieron una alternativa que llamaron SSR (Semantic Similarity Rating). La idea es elegante:

En lugar de pedir un número, le pides a la IA que escriba una reacción honesta al producto. Dos o tres frases. Como si fuera un consumidor real dando su opinión espontánea.

Después, usas embeddings (representaciones matemáticas del texto) para medir qué tan cerca está esa respuesta de frases ancla predefinidas. Por ejemplo: "Definitivamente compraría esto" en un extremo, "Jamás compraría esto" en el otro.

La distancia entre la respuesta generada y esas frases ancla te da un puntaje continuo. Y ese puntaje, a diferencia de la calificación directa, sí replica con precisión cómo responden los humanos.

El diagrama muestra tres formas de medir intención de compra con IA. Arriba (A): el flujo de cada método, desde pedirle al modelo que adopte un perfil demográfico hasta obtener un puntaje. Abajo (B): cómo el método SSR mapea una respuesta textual a un puntaje, comparando su posición en el espacio de embeddings contra frases de referencia. Fuente: Maier et al., 2025.

¿Por qué funciona? Porque el lenguaje natural tiene matices que un número no captura.

"Se ve interesante pero no sé si vale lo que cuesta" y "Lo necesito ahora" podrían ser un 7 en una escala numérica. Pero en términos de intención de compra real, son mundos diferentes. El método SSR captura esa diferencia.

El segundo ingrediente: las personas

Hay otro hallazgo del estudio que es fácil pasar por alto.

Si le preguntas a la IA sin darle contexto demográfico, sus respuestas son genéricas y excesivamente positivas. Demasiado educadas. Demasiado neutrales.

Pero si le asignas una "persona" —edad, género, nivel de ingreso, hábitos de compra— la IA replica los sesgos reales de ese segmento.

Una persona con presupuesto ajustado se vuelve más sensible al precio. Una persona que busca productos premium tolera precios altos pero exige calidad percibida. Una persona escéptica hace más preguntas antes de decidir.

El estudio validó esto con modelos como GPT-4, Gemini y Llama. Los modelos más grandes (más de 70 mil millones de parámetros) fueron mejores replicando las diferencias demográficas.

Qué puedes hacer con esto

La aplicación práctica es directa.

Antes de gastar en ads para validar un concepto, antes de pagar un panel de consumidores, antes de lanzar una campaña para "ver qué pasa", puedes simular las reacciones de diferentes segmentos.

Creas 5 perfiles distintos: el comprador impulsivo, el que siempre compara precios, el escéptico, el que busca premium, el que tiene prisa. Le presentas tu producto o tu descripción a cada uno. Les pides una reacción honesta, no una calificación.

Si todos reaccionan tibio, el problema no es el público. Es el concepto. Y lo descubriste en 10 minutos en lugar de 3 semanas y $1,500 USD en tráfico pagado.

También puedes usarlo para iterar copy. Si la IA dice "me gusta pero el empaque se ve frágil", ya sabes qué objeción atacar en tu descripción. Si dice "no entiendo para qué sirve", tu propuesta de valor no está clara.

El feedback cualitativo —el "por qué" detrás de la reacción— resultó ser más rico y específico que el de los paneles humanos tradicionales. Los humanos en encuestas tienden a dar respuestas cortas y vagas. La IA, configurada correctamente, te dice exactamente qué atributo le gustó o le preocupó.

Lo que esto no hace

Antes de que salgas a cancelar tu próximo estudio de mercado, hay límites claros.

La IA no puede predecir reacciones a experiencias físicas. Sabor, textura, olor, sensación en la piel. Si vendes comida o skincare o ropa, la prueba real sigue siendo insustituible.

Tampoco reemplaza vender de verdad. Una cosa es que un consumidor sintético diga "lo compraría" y otra es que alguien saque su tarjeta. La intención de compra no es lo mismo que la compra.

Y no te dice nada sobre si tu operación puede entregar lo que promete. Tiempos de envío, atención al cliente, calidad real del producto. Eso sigue dependiendo de ti.

Pero para las etapas tempranas como filtrar ideas, probar conceptos e iterar descripciones antes de invertir, el método está validado. Funciona.

La pregunta final

Si un estudio científico acaba de demostrar que puedes replicar el 90% de la confiabilidad de un panel humano con IA, ¿por qué seguirías pagando $4,000 USD por un focus group tradicional?

La respuesta honesta: porque la mayoría de la gente no sabe que esto existe. O porque lo intentaron mal (pidiendo calificaciones numéricas) y concluyeron que no servía.